Ⅱ. 应用场景:从实验室到产业落地

◉ 生产力工具的重构

Ⅲ. 生态布局:芯片厂商的合纵连横

◆ 英特尔:构建友好型生态

微软推出Windows Colot框架,提供20+预置AI API(如图像超分、实时OCR),3步即可集成功能12;其AIPC加速计划已孵化200+ISV,涵盖医疗影像分析、工业质检等40余个中本土例7。

Ⅳ. 挑战与展望:算力狂飙下的冷思考

▷ 能效比瓶颈

当前NPU能效比虽达20TOPS/W,但运行千亿级模型仍需50W以上功耗,移动端续航压力显著12。

▶︎ 移动端突破:Galaxy S24 Ultra的端侧实践

尽管未公开芯片细节,但其NPU驱动的Galaxy AI已实现通话实时翻译、图片语义搜索等功能,所有数据处理均在设备端完成,隐私保护级别达到金融加密标准10。

▶︎ 苹果M3 Ultra:大模型本地化的里程碑

通过UltraFusion封装技术整合两颗M3 Max芯片,M3 Ultra的神经引擎心数翻倍,支持512G统一内存与800G/s带宽,可本地运行超6000亿参数的LLM8。其80GPU配合32CPU,在图像生成、科学模拟等场景展现优势,例如Stable Diffusion推理速度较前代提升2.6倍。

▷ 开发范式转型

多架构并行编程复杂度高,英特尔通过oneAPI简化跨平台开发,但仍需掌握OpenVINO、ONNX等工具链712。

▷ 未来趋势

◆ 苹果:封闭生态的开放尝试

M3 Ultra虽未开放第三方NPU调用,但通过Core ML框架优化了TensorFlow/PyTorch模型转换效率,在Mac Studio设备上运行Llama 2-70的延迟降低40%8。

(全文共计约850字,综合文献6781012)

- 星环无涯问知:基于酷睿Ultra的本地RAG技术,可在断网环境下解析百页金融报告,生成带数据溯源的12;

- 万兴喵影:利用NPU加速4K视频超分,处理速度提升228%,AI成片功能3分钟生成Vlog6;

- Flowy会议助手:通过NPU实时转写录音,GPU同步生成摘要,CPU整理待办事项,全程功耗不足5W7。

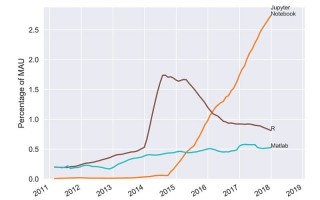

◉ 科研与开发的算力

苹果M3 Ultra支持6000亿参数模型本地运行,使生物信息学、量子化学等领域的研究者无需依赖云服务器即可完成分子动力学模拟8;英特尔OpenVINO工具链则让通过统一接口调用CPU/GPU/NPU资源,缩短AI应用开发周期12。

- 算力分层化:2025年Panther Lake预计NPU算力再增50%,支持视频生成等复杂任务12;

- 边缘-云协同:类似星环科技的云边算力均衡方,将成模型部署主流7;

- 安全冗余设计:硬件级TEE(可信执行环境)或成Ultra芯片标配,满足医疗、金融等领域数据合规需求10。

:超越摩尔定律的AI芯片新

Ultra芯片通过架构创新与生态整合,正将AI计算从数据中心推向设备边缘。随着英特尔、苹果等厂商持续迭代,未来5年或将见证“人均拥有超算级AI终端”的产业奇点——这不仅重塑硬件形态,更将引发从科研方到商业模式的链式。

从架构到生态:Ultra芯片如何重构AI计算边界

——异构集成与边缘智能的双重

Ⅰ. 技术架构:从单一算力到三位一体

▶︎ 英特尔酷睿Ultra:AI PC的神经中枢

基于Meteor Lake架构的第二代酷睿Ultra,首次实现CPU(24)+GPU(80)+NPU(48TOPS)的异构设计,总算力突破120TOPS612。其NPU模块采用低功耗设计,支持持续运行实时字幕、视频超分等任务,而GPU专精大模型推理加速,CPU则处理即时型AI需求。这种分工使搭载该芯片的设备在18小时续航下,仍可同步处理多模态AI任务7。

相关问答

处理器

AI的使用涉及多个步骤,以下是基本的使用流程:安装与配置:首先,确保你的设备兼容并安装了Ultra处理器AI软件。通常,这涉及到从官方网站下载并安装最新版本的软件。安装完成后,打开软件并按照提示进行初始设置和配置。数据准备:在使用AI功能之前,你需要准备要处理的数据。这可能包括图像、音频...